Para poder entrar de lleno al tema debo hacer referencia a la trilogía El Paralaje Neanderthal, de Robert Sawyer, cuya trama gira alrededor de un portal abierto entre dos dimensiones, producto de un computador cuántico en la otra dimensión, una copia de la tierra donde la especie dominante son los neanderthal y no los cromagnon.

En la nuestra se vienen desarrollando prototipos de computadores cuánticos desde hace tiempo, y en el momento en que sean viables darán un impulso al desarrollo tecnológico comparable al paso de la regla de cálculo a una Workstation de cuatro procesadores en paralelo y con una cantidad obscena de memoria RAM.

Procesando con cuántica

La computación cuántica comienza donde termina la Ley de Moore, que según cálculos se agotará alrededor del 2020, cuando la miniaturización llevará los circuitos al nivel de átomos y moléculas. Sin embargo, a diferencia del computador que abre el portal en El Paralaje, en esta dimensión tenemos computadores cuánticos bastante primitivos aún.

Uno de los renombrados en su tiempo fue el IBM Research5-qubit, que contiene cinco qubits: cinco átomos de flúor dentro de una molécula especialmente diseñada, de modo que los núcleos del flúor interactúen entre sí como bits de memoria. Para ponerla a prueba se empleó un problema conocido como «localización del orden», que consiste en la localización del periodo de una función particular, lo cual es típico de muchos problemas matemáticos básicos necesarios para aplicaciones informáticas como la criptografía, por ejemplo.

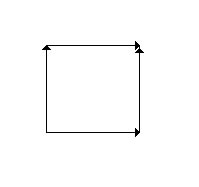

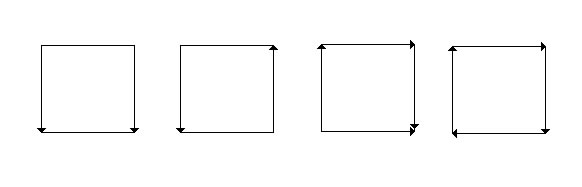

El problema puede ejemplificarse considerando un número determinado de habitaciones y un mismo número de pasillos ubicados al azar, algunos de los cuales conducen a una misma habitación. Se supone que, en cierto momento, una persona que avance por los pasillos y recorra las habitaciones volverá al punto de partida. El problema consiste en calcular, con el menor número de iteraciones, el número mínimo de transiciones que se requerirían para volver al punto inicial. El computador cuántico resolvió el problema en un sólo paso, mientras que uno convencional requeriría de hasta cuatro pasos.

Si bien el potencial de la computación cuántica es inmenso, y los últimos avances han sido muy prometedores para su desarrollo, quedan aún enormes retos por delante, antes de que estas máquinas sean accesibles al público. Si bien los computadores cuánticos serán fundamentales para la elaboración de bases de datos y para resolver problemas matemáticos complejos, es improbable que puedan usarse para procesamiento de palabras, o para navegar por Internet.

Podría especularse que los computadores cuánticos aparecerán mucho más temprano que tarde en centros de alta tecnología y complejos militares, pero a pesar de todo su potencial los computadores cuánticos no serían nada sin casi un siglo de investigación y desarrollo en superconductores.

Los superconductores

Los superconductores son metales y aleaciones que presentan cero resistencia a la corriente eléctrica a temperaturas muy bajas, típicamente inferiores a 13°K. Los superconductores se han empleado para construir electroimanes poderosos, pero las temperaturas necesarias para que estos materiales presenten propiedades superconductoras son demasiado bajas, lo que ha impedido que su uso se haya difundido.

En 1911, el científico holandés Heike Kamerlingh Onnes de la Leiden University logró bajar la temperatura del mercurio a 4ºK y observó una extraña característica en él. Se dio cuenta que la resistencia eléctrica del mercurio a esa temperatura repentinamente desapareció, fenómeno que bautizó como superconductividad.

Años más tarde, en 1933, los científicos Walter Meissner y Robert Ochsenfeld descubrieron que los materiales superconductores tienen la capacidad de repeler un campo magnético actuando como material diamagnético. Esto fue conocido más tarde como Efecto Meissner, y se ha descubierto que es tan fuerte que puede hacer levitar un imán colocado sobre un superconductor.

El primer avance teórico ampliamente aceptado sobre la superconductividad fue hecho en 1957 por los físicos norteamericanos John Bardeen, Leon Cooper y John Schrieffer, el cual fue llamado la Teoría BCS (por las iniciales de cada apellido) y que les hizo merecedores del Premio Nobel en Física en el año 1972. Esta teoría explica la superconductividad de elementos y aleaciones simples con temperaturas cercanas al cero absoluto, pero no es válida en la explicación del fenómeno a temperaturas mayores.

Un descubrimiento increíble sobre superconductividad fue hecho en 1986, cuando Alex Müller y Georg Bednorz, investigadores del IBM Research Laboratory, crearon un compuesto cerámico superconductor con la más alta temperatura registrada hasta entonces: 30°K. Este descubrimiento, (que les hizo merecedores del Premio Nobel de Física en el año 1987), fue notable, ya que generalmente las cerámicas son empleadas como aisladores puesto que no conducen corriente eléctrica.

Fue así como una nueva época en la historia de los superconductores nació dando paso a los superconductores de alta temperatura. Investigadores de todo el mundo empezaron a “crear” cerámicas de cualquier posible combinación para obtener superconductores de mayor temperatura. Actualmente, el récord mundial de temperatura para un superconductor de alta temperatura (conocidos como HTS: High Temperature Superconductor) es de 138°K, pero ello será tema para un artículo posterior.

Brian D. Josephson

Maliciosamente omití en la sección anterior al físico británico Brian David Josephson, nacido en 1940 en Cardiff (Glamorgan, Gales), que predijo a los 22 años que la corriente eléctrica podría fluir entre dos materiales superconductores. Antes de obtener su doctorado en 1964, Josephson se interesó en la superconductividad, y empezó a explorar las propiedades de una juntura entre dos superconductores, que sería conocida después como Unión Josephson.

Josephson demostró teóricamente en 1962 que en este tipo de unión los pares de Cooper (la asociación de dos electrones), que dan al superconductor su resistencia nula, son capaces de pasar de un lado a otro a través del aislante por efecto túnel (fenómeno mediante el cual los electrones, operando como onda, pueden penetrar sólidos; había sido estudiado anteriormente por los físicos Esaki y Giaever).

El efecto túnel entre dos superconductores podía tener características muy especiales, como por ejemplo el flujo de electrones a través de una capa aislante sin la aplicación de voltaje; al aplicar un voltaje, la corriente deja de fluir y oscila a gran frecuencia; se puede decir que el conjunto se comporta como si fuese un nuevo superconductor más grande a pesar de la resistencia del aislante. Éste es el efecto Josephson y es aplicado en instrumentos capaces de detectar campos magnéticos muy débiles .

Cuando Josephson propuso esta idea, era tan increíble que ni siquiera su director de tesis quiso ser coautor. El artículo fue enviado a una revista que por aquel entonces era nueva, con la esperanza que ante la necesidad de material publicaran casi cualquier cosa; el artículo se publicó y más tarde Josephson recibiría el premio Nobel de física en 1973, junto a Esaki y Giaever.

La experimentación confirmó el efecto, y su aplicación a su vez reforzó la anterior Teoría BCS. Aplicando los descubrimientos de Josephson con superconductores, los investigadores de IBM habían ensamblado para 1980 un computador experimental de velocidades de cálculo de 10 a 100 veces superior que aquellas logradas con los chips de silicio convencionales de la época.

La unión Josephson

Como mencioné en el párrafo anterior, el efecto Josephson puede emplearse en la detección de campos magnéticos muy débiles. De hace un tiempo se han venido empleando uniones Josephson para medir campos magnéticos con extrema precisión, circuitos electrónicos, puertas lógicas, amplificadores y células de memoria entre otras aplicaciones.

En el régimen clásico la unión Josephson se comporta como un inductor (bobina), pero hace un tiempo se predijo que también se puede comportar como una capacitancia (condensador) si la unión es lo suficientemente pequeña.

Ahora Per Delsing y un equipo de la Universidad Tecnológica de Chalmers en Suecia, e independientemente, Pertti Hakonen y sus colaboradores de la Universidad Tecnológica de Helsinki y del Instituto Landau de Física Teórica de Moscú han observado este comportamiento capacitivo por primera vez.

Uno de los problemas de diseño de un computador cuántico es que las múltiples superposiciones de estado, que permitirían la ejecución de innumerables operaciones simultáneamente, son tan frágiles que el intento de leerlas las destruye. Este comportamiento capacitivo podría usarse para medir, sin destruirlo, el estado cuántico de los qubits en un futuro computador cuántico. De hecho, Hakonen ha usado este modelo para leer el valor de un qubit sin alterar su valor.

Según Mika Sillanpaa, en un futuro la unión Josephson podría usarse para operaciones a gran escala en ordenadores cuánticos; y la inductancia y capacitancia de la unión Josephson juntas podrían permitir la construcción de nuevos tipos de dispositivos electrónicos tales como amplificadores paramétricos de bajo ruido.

Límites actuales al rendimiento de los computadores

El progreso en la tecnología computacional basada en semiconductores ha sido espectacular en las últimas décadas. Pero mientras las densidades en los circuitos se verán incrementadas en el futuro, será más difícil mejorar la velocidad de procesamiento, y, en particular, el rendimiento de los sistemas. Ocurre así porque el calor generado por la operación de los chips semiconductores de alto rendimiento ya es tan grande que no puede ser transferido directamente desde el chip al fluido refrigerante (por ejemplo el aire, en un sistema de escritorio o un portátil).

El chip debe en cambio unirse a disipadores de calor para incrementar la interfase sólido—líquido (usualmente una placa en contacto con aire impulsado por un ventilador en los computadores actuales) y prevenir las fugas termales con temperaturas excesivas en el chip. Sin embargo los disipadores de calor son, por necesidad, voluminosos, y no permiten empaquetamientos densos en el chip.

Puesto que las señales eléctricas viajan a velocidad finita – de hecho, no más de 1.5 cm en 100 ps en líneas de transmisión – es evidente que las conexiones deben mantenerse pequeñas de forma que los retrasos de las señales dentro del chip y a través del circuito no disminuyan la alta velocidad de procesamiento del computador.

Puede decirse que mejoras en la velocidad de procesamiento bajo los 100 ps son inconsecuentes para sistemas computacionales de alto rendimiento, a menos que el enfriamiento y el empaquetamiento del chip pueda revolucionarse de forma similar. La unión Josephson, con su baja disipación de potencia y alta velocidad de procesamiento inherente, provee la respuesta a ambos problemas.

Potencial del efecto Josephson

El potencial de los hipotéticos computadores cuánticos basados en esta nueva tecnología desafía la imaginación: velocidades de cálculo más de diez veces superior a la velocidad actual de los computadores más rápidos de hoy día, con lógica miniaturizada que disipa menos de una milésima de la potencia de los actuales dispositivos basados en semiconductores VLSI (Very Large Scale Integration, integración a muy alta escala).

Dos atributos de los computadores cuánticos basados en el efecto Josephson tienen la clave de este gran potencial: velocidad de cálculo de 10 ps o menos y disipación de potencia para cada elemento medido en uW. Características impresionantes como estas no se consiguen fácilmente. Para alcanzar la superconductividad, los dispositivos Josephson deben enfriarse a 4ºK por inmersión en helio líquido. La física de estos dispositivos involucra una mezcla de mecánica cuántica, electromagnetismo y teoría de superconductores.

Gracias a su baja disipación de potencia, las uniones Josephson eliminan la necesidad de elaborar disipadores de calor, requeridos por los actuales chips semiconductores de alto rendimiento. Sin disipadores de calor, un empaquetamiento (integración) más denso puede ser logrado, resultando en una reducción tanto del tamaño general del computador como del retraso de la señal entre los chips.

La refrigeración directa de los dispositivos Josephson por inmersión en helio líquido, a pesar de requerir una ingeniería cuidadosa, es enteramente factible hoy en día: los criostatos de helio ya están actualmente en uso para una variedad de aplicaciones.

Pros y contras de la baja temperatura

Puesto que los dispositivos Josephson operan a sólo unos pocos grados sobre el cero absoluto, deben sumergirse en helio liquido. Hirviendo a presión atmosférica, el helio liquido mantiene una temperatura de 4.2ºK. La baja temperatura es a la vez beneficiosa y dañina.

Un aspecto beneficioso es que cables superconductores pueden ser usados muy delgados, lo que ayuda al proceso LSI. Otro beneficio de las temperaturas muy bajas es que el ruido (distorsión de las señales) a causa de la energía termal es aproximadamente 90 veces menor a 4ºK que a 350ºK, donde los dispositivos semiconductores usualmente operan.

Reacciones químicas y físicas tales como difusión, corrosión y electromigración están también virtualmente detenidas a 4ºK. Éstos y otros factores ofrecen el potencial para una operación ultraconfiable, a condición de que, por supuesto, no se presenten nuevos tipos de falla producidos por el ambiente de baja temperatura, tales como expansión termal: un potencial problema que puede resolverse eligiendo los materiales adecuados.

Por otra parte, la necesidad de ambientes de baja temperatura supone un costo agregado de mantenimiento por el criostato y los refrigeradores de helio liquido, además de los inconvenientes de mantener y dar servicio a computadores en un ambiente criogénico.

Volando sin red

Cuando la actual tecnología de superconductores de alta temperatura sea superada, requiriendo de temperaturas de 165-170ºK para operar (puede sonar mucho, pero no es menos que la temperatura de un congelador doméstico) podremos ver desarrollos que hoy son materia de ciencia ficción.

Podrá haber computadores lo suficientemente rápidos para albergar inteligencias artificiales que puedan interpretar simultáneamente o que puedan ejecutar software de interpretación de modo que reemplacen a las actuales secretarias, mucho más eficientes y menos adictas a conversar por teléfono.

Estos computadores podrán tener la suficiente capacidad de cálculo de modo de poder mantener proyecciones actualizadas al minuto de la economía mundial, y de todos los posibles escenarios dependiendo del movimiento de los índices económicos, así como proporcionar un análisis estadístico minucioso de las diferentes tendencias en el comercio mundial.

Tal vez podrá realizarse el proyecto del túnel submarino Nueva York – Londres, previamente simulado informáticamente para lograr el mejor diseño. Si alguna vez se ejecuta el proyecto de la pirámide de la bahía de Tokio, probablemente en su proyección se encontrará involucrado un computador cuántico.

Probablemente cuando los primeros computadores cuánticos entren en operación de forma confiable serán parecidos a UNIVAC, que ocupaba una gran habitación herméticamente sellada y que operaba a una temperatura constante de 50ºC: verdaderos mastodontes a los que el acceso estaba restringido a personas del mundo académico y militar. Nadie pensaba en esos años que muchas veces la capacidad de UNIVAC hoy podía encontrarse en algo tan diminuto como un reproductor de mp3, sumergido en las profundidades de un bolsillo o una cartera.

Tal vez un par de siglos después de la masificación de la computación cuántica, con superconductores a temperatura ambiente baratos y confiables, la humanidad será tan tecnodependiente que tal vez las decisiones importantes serán dejadas a cargo de un computador, que decidirá el rumbo de los países y de los proyectos científicos. La prensa escrita será de autoría de alguna IA, y la administración de pequeñas empresas y estados estará en manos de algún computador cuántico corporativo.

Si soñar no cuesta nada, probablemente todos llevaremos un computador cuántico en un implante que se dedique a grabar en forma permanente nuestro entorno, conectarse inalámbricamente a una base de datos, ordenar una pizza, interpretar simultáneamente cuando estemos visitando un país de lengua desconocida, dar aviso en caso de emergencia, recordar las citas y las fechas importantes, todo ello energizado por la temperatura corporal o por un generador hemodinámico.

Lo cierto es que cada vez que nuestra tecnología informática da un salto hacia delante, también el desarrollo da un gran paso; esperamos que la capacidad que proporcionen los computadores cuánticos sea empleada no para planear la obliteración del algún difuso y probablemente inexistente Eje del Mal, sino para el desarrollo de curas para enfermedades que hoy no son curables, para la recuperación del medio ambiente y la exploración de nuevos lugares.

ensayos

brainstorming

Se ha dicho que el nivel de vida y el grado de desarrollo de una civilización humana dependen de la disponibilidad de energía que tiene. En un pasado no tan remoto, el hombre disponía solamente de su propia musculatura para hacer el trabajo físico. Más adelante la mayoría de las civilizaciones tuvieron a su disposición animales domésticos para carga y tiro, tales como caballos, bueyes, camellos, elefantes y llamas. Además, aprendieron a utilizar algunos recursos naturales en su provecho, como la luz solar que permitía la agricultura; las corrientes de aguas que movían las ruedas de molinos; y la

Se ha dicho que el nivel de vida y el grado de desarrollo de una civilización humana dependen de la disponibilidad de energía que tiene. En un pasado no tan remoto, el hombre disponía solamente de su propia musculatura para hacer el trabajo físico. Más adelante la mayoría de las civilizaciones tuvieron a su disposición animales domésticos para carga y tiro, tales como caballos, bueyes, camellos, elefantes y llamas. Además, aprendieron a utilizar algunos recursos naturales en su provecho, como la luz solar que permitía la agricultura; las corrientes de aguas que movían las ruedas de molinos; y la  La literatura de ciencia ficción en Chile fue sacudida, a fines del tercer trimestre de 2005, por Ygdrasil, la ópera prima de Jorge Baradit. Considerando lo pequeño de la oferta de género fantástico en Chile, resulta curioso y tal vez injusto que la obra de ciencia ficción comentada en estas líneas, aparecida casi al mismo tiempo que Ygdrasil, haya pasado casi sin levantar una mota de polvo en la prensa.

La literatura de ciencia ficción en Chile fue sacudida, a fines del tercer trimestre de 2005, por Ygdrasil, la ópera prima de Jorge Baradit. Considerando lo pequeño de la oferta de género fantástico en Chile, resulta curioso y tal vez injusto que la obra de ciencia ficción comentada en estas líneas, aparecida casi al mismo tiempo que Ygdrasil, haya pasado casi sin levantar una mota de polvo en la prensa.