Me van a disculpar la ordinariez, pero estoy hasta los huevos de documentales de astronomía. En serio.

No me malinterpreten, me gustan mucho, pero modestamente ya me conozco la trama de todos y ahora más bien ejercen una influencia «actualizadora» en mí (onda, poniéndome al día cuando aparecen descubrimientos nuevos), mientras que en un novato la influencia ejercida es «cautivadora» (onda, para recién atraer al curioso, cosa que yo ya no necesito :)). Continue reading «¿Hacia una evolución 2.0?»

Etiqueta: Ciencia

From the earth to the moon: El futuro que vino y se fue

From the earth to the moon es una miniserie del HBO emitida el año 1998. Recuerdo que cuando la emitieron no tuve oportunidad de verla completa (sólo un par de capítulos sueltos) e ignoro si alguna vez la re-transmitieron. Y bueno, la ocasión llegó más de una década más tarde, cuando finalmente me di el tiempo de verla completa.

From the earth to the moon es una miniserie del HBO emitida el año 1998. Recuerdo que cuando la emitieron no tuve oportunidad de verla completa (sólo un par de capítulos sueltos) e ignoro si alguna vez la re-transmitieron. Y bueno, la ocasión llegó más de una década más tarde, cuando finalmente me di el tiempo de verla completa.

La serie toma su nombre de la novela de Julio Verne, aunque no tiene relación con ella y narra la historia de la carrera espacial norteamericana(*), pero no desde la perspectiva del documental tipo NatGeo, ni de lo técnico ni de las efemérides Continue reading «From the earth to the moon: El futuro que vino y se fue»

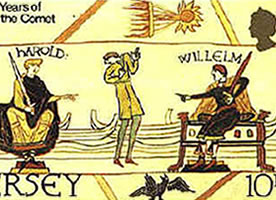

Thomas Harriot: el astrónomo que madrugó a Galileo

Aunque bastan los ojos (y en lo posible una noche oscura alejados de la ciudad), para maravillarse con la inmensidad del cosmos, es del todo evidente que sólo gracias al uso de instrumentos de observación (tecnologías ópticas y no ópticas) es que ha sido posible alcanzar el nivel de conocimientos que actualmente tenemos acerca del Universo. Esto se confirma al estudiar la historia de la ciencia, en donde se puede identificar, como un punto clave en el desarrollo de la astronomía, a la primera observación telescópica que realizó Galileo Galilei (1564-1642) en el año 1609. Continue reading «Thomas Harriot: el astrónomo que madrugó a Galileo»

Aunque bastan los ojos (y en lo posible una noche oscura alejados de la ciudad), para maravillarse con la inmensidad del cosmos, es del todo evidente que sólo gracias al uso de instrumentos de observación (tecnologías ópticas y no ópticas) es que ha sido posible alcanzar el nivel de conocimientos que actualmente tenemos acerca del Universo. Esto se confirma al estudiar la historia de la ciencia, en donde se puede identificar, como un punto clave en el desarrollo de la astronomía, a la primera observación telescópica que realizó Galileo Galilei (1564-1642) en el año 1609. Continue reading «Thomas Harriot: el astrónomo que madrugó a Galileo»

Charles Darwin, en el bicentenario de su nacimiento

Dada la costumbre de recordar de manera especial a grandes personajes o acontecimientos históricos relevantes, cuando se conmemora algún aniversario significativo, no cabe duda que la agenda de este año incluirá múltiples homenajes a Charles Darwin (1809-1882), el famoso naturalista inglés de quien, este 12 de febrero, se celebra el bicentenario de su nacimiento. Y del cual, ya al finalizar el año (el 24 de noviembre), se recordará el 150 aniversario de la publicación de su principal obra.

Dada la costumbre de recordar de manera especial a grandes personajes o acontecimientos históricos relevantes, cuando se conmemora algún aniversario significativo, no cabe duda que la agenda de este año incluirá múltiples homenajes a Charles Darwin (1809-1882), el famoso naturalista inglés de quien, este 12 de febrero, se celebra el bicentenario de su nacimiento. Y del cual, ya al finalizar el año (el 24 de noviembre), se recordará el 150 aniversario de la publicación de su principal obra.

Charles Darwin es, sin lugar a dudas, uno de los científicos más importantes de Continue reading «Charles Darwin, en el bicentenario de su nacimiento»

Evolución estelar. Vida frente a los ojos de un Sol

Al elevar nuestra mirada al cielo, podremos maravillarnos frente a la hermosura de un imponente cosmos, sintiendo a la vez, una cierta seguridad y tranquilidad, al pensar que los objetos que estamos observando se mantendrán inamovibles por los siglos y siglos venideros.

Pero la ciencia nos detiene por un momento este pensamiento y nos demuestra, que como todo en la vida, se produce un nacimiento, un desarrollo y un desenlace que se forja en cada entidad producida en este universo.

De esta forma, pasaremos a ver y Continue reading «Evolución estelar. Vida frente a los ojos de un Sol»

¿Qué aportan los observatorios astronómicos al país?

Un mito que circula a veces es que los observatorios astronómicos sólo sirven a países extranjeros que envían a su gente a llevarse datos que no comparten con las universidades chilenas. Por tanto, se pregunta la gente, ¿de qué le sirve a Chile prestar su territorio y apoyar la instalación de estos proyectos? Quiero responder a esto precisamente desde mi perspectiva de científico chileno.

Un mito que circula a veces es que los observatorios astronómicos sólo sirven a países extranjeros que envían a su gente a llevarse datos que no comparten con las universidades chilenas. Por tanto, se pregunta la gente, ¿de qué le sirve a Chile prestar su territorio y apoyar la instalación de estos proyectos? Quiero responder a esto precisamente desde mi perspectiva de científico chileno.

El primer obvio beneficio es tener acceso a usar instrumentos científicos que constituyen el estado del arte en la materia, pero lo increible es que Continue reading «¿Qué aportan los observatorios astronómicos al país?»

¿Vivimos en un holodeck?

Si alguien me dijera que los alemanes tienen un interferómetro láser de 600 metros de longitud escondido en alguna parte de la campiña al sur de Hannover, probablemente me asustaría un poco. Sobretodo porque no sé que diablos es un interferómetro láser, pero es un nombre inquietante (más aún uno de 600 metros de largo).

Si alguien me dijera que los alemanes tienen un interferómetro láser de 600 metros de longitud escondido en alguna parte de la campiña al sur de Hannover, probablemente me asustaría un poco. Sobretodo porque no sé que diablos es un interferómetro láser, pero es un nombre inquietante (más aún uno de 600 metros de largo).

Desde luego, exagero. Sé lo que es un interferómetro láser, lo que no sé es cómo funciona. Pero el punto es que el mundo a nuestro alrededor está lleno de cosas enormes, brutalmente ingeniosas e incluso Continue reading «¿Vivimos en un holodeck?»

Astros que rigen nuestras vidas

Esa mañana tomé la revista de espectáculos y la comencé a hojear con cierto desenfado. Era sábado y me encontraba de descanso, después de una semana ajetreada. Leí algunos artículos banales, me enteré de las privacidades de los famosos y llegue a las últimas páginas. Invariablemente en este tipo de publicaciones encontramos esta socorrida sección, la de los horóscopos. Para mi signo decía: «Hoy será un día ajetreado. No emprenda trabajos demasiado complejos o podría terminar en desagradables fracasos. Su número de la suerte es 7». Lo anterior apoyaba mi tesis de Continue reading «Astros que rigen nuestras vidas»

Esa mañana tomé la revista de espectáculos y la comencé a hojear con cierto desenfado. Era sábado y me encontraba de descanso, después de una semana ajetreada. Leí algunos artículos banales, me enteré de las privacidades de los famosos y llegue a las últimas páginas. Invariablemente en este tipo de publicaciones encontramos esta socorrida sección, la de los horóscopos. Para mi signo decía: «Hoy será un día ajetreado. No emprenda trabajos demasiado complejos o podría terminar en desagradables fracasos. Su número de la suerte es 7». Lo anterior apoyaba mi tesis de Continue reading «Astros que rigen nuestras vidas»

El fin del mundo se acerca

El 28 de marzo de 2008 siete mujeres de la secta Verdadera Iglesia Ortodoxa Rusa decidieron deponer su autoencierro en una cueva al Sur de Moscú. El enclaustramiento había durado cinco meses, y aún quedaba una treintena de personas que rehusaba abandonar el lugar. ¿La razón? La misma que motivó su ingreso allí: según el grupo, el mundo se acabaría en mayo de 2008. Un autoproclamado profeta les había anunciado este evento basándose en su personal decodificación de la Biblia. Continue reading «El fin del mundo se acerca»

El 28 de marzo de 2008 siete mujeres de la secta Verdadera Iglesia Ortodoxa Rusa decidieron deponer su autoencierro en una cueva al Sur de Moscú. El enclaustramiento había durado cinco meses, y aún quedaba una treintena de personas que rehusaba abandonar el lugar. ¿La razón? La misma que motivó su ingreso allí: según el grupo, el mundo se acabaría en mayo de 2008. Un autoproclamado profeta les había anunciado este evento basándose en su personal decodificación de la Biblia. Continue reading «El fin del mundo se acerca»

Stephen Hawking y la Teoría del Todo

En cada época del devenir de la humanidad han existido personas excelsas que se han destacado por sobre el resto de sus congéneres. Así, innumerables gobernantes, religiosos, héroes militares, artistas y deportistas, entre otros, han ganado un espacio entre los escogidos. E incluso, algunos de ellos, aún en vida, se vieron ya envueltos por una aureola de leyenda e inmortalidad.

En cada época del devenir de la humanidad han existido personas excelsas que se han destacado por sobre el resto de sus congéneres. Así, innumerables gobernantes, religiosos, héroes militares, artistas y deportistas, entre otros, han ganado un espacio entre los escogidos. E incluso, algunos de ellos, aún en vida, se vieron ya envueltos por una aureola de leyenda e inmortalidad.

Y aunque para muchos pueda parecer sorprendente, también entre estos destacados de todos los tiempos figuran algunos científicos. Continue reading «Stephen Hawking y la Teoría del Todo»